E資格受験に必要なJDLA認定講座の一つであるラビット・チャレンジ(https://ai999.careers/rabbit/)のレポート用ページです。

100文字以上要点まとめ

過学習

テスト誤差と訓練誤差とで学習曲線が乖離すること

特定の訓練サンプルに対して特化して学習する

【原因】

ネットワークの自由度(層数、ノード数、パラメータの値など)が高い

入力値小でネットワーク大のとき起きやすい

L1正則化、L2正則化

【正則化とは】

ネットワークの自由度を制約すること

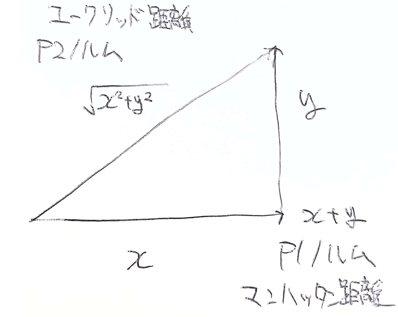

\( E_n(w)+\frac{1}{p}{||x||}_p \)

\( {||x||}_p = {({|x_1|}^p+…+{|x_n|}^p)}^{\frac{1}{p}}\)

誤差関数にpノルムを加える

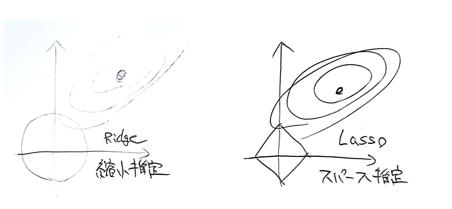

p=1:L1正則化(Lasso)

p=2:L2正則化(Rigde)

ドロップアウト

【過学習の課題】

ノードの数が多い

【ドロップアウトとは】

ランダムにノードを削除して学習させること

【メリット】

データ量を変化させずに異なるモデルを学習させていると解釈できる

実装演習

確認テスト

①線形モデルの正則化手法の中にリッジ回帰という手法がありその特徴として正しいものは?

(b)ハイパーパラメータを0に設定すると非線形回帰となる(正則化項なしと等価)

②下図について、L1正則化を表しているグラフはどちらか答えよ。

右

時間

12/15 1:20

コメント