E資格受験に必要なJDLA認定講座の一つであるラビット・チャレンジ(https://ai999.careers/rabbit/)のレポート用ページです。

100文字以上要点まとめ

勾配降下法

深層学習の目的

学習を通して誤差を最小にするネットワークを作成する

⇒誤差を最小化するパラメータを発見すること

⇒勾配降下法を利用してパラメータを最適化

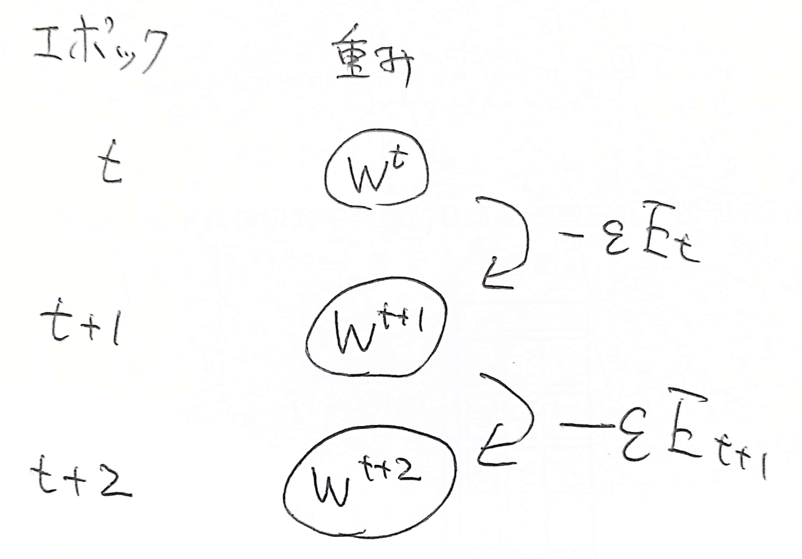

\( w^{(t+1)} = w^{(t)} -\epsilon \nabla E \)

\(\epsilon:学習率 \)

学習率

大きすぎ⇒最小にたどり着かず発散

小さすぎ⇒収束までに時間かかる。極小につかまり最小値にたどり着かない

学習率の決定、収束性向上のため下記アルゴリズムがよく利用されている

Momentum

AdaGrad

Adadelta

Adam←よく使う

確率的勾配降下法

ランダムに抽出したサンプルの誤差を使用

メリット

データが冗長な場合の計算コストの軽減

望まない局所極小解に収束するリスクの軽減

オンライン学習ができる(都度都度少しずつデータを与えて学習。最初に全部必要でなはい)

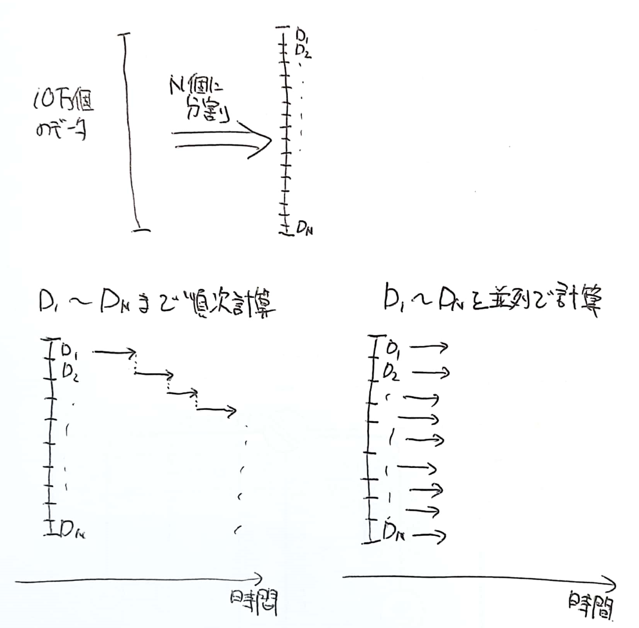

ミニバッチ勾配降下法

ランダムに分割したデータ集合(ミニバッチ)Dtに属するサンプルの平均誤差

メリット

確率的勾配降下法のメリットを損なわず、計算資源を有効活用できる

並列化で高速化できる

\( w^{(t+1)} = w^{(t)} -\epsilon \nabla E_t \)

\( E_t = \frac{1}{N_t} \sum_{n∈D_t} E_n \)

\( N_t = |D_t| \)

実装演習

確認テスト

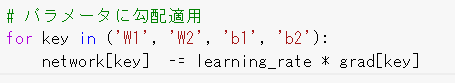

①勾配降下法の重み更新の式に該当するソースコードを探してみよう

②オンライン学習とはなにか

学習データが入ってくるたびに都度パラメータを更新し学習を進めていく方法

一方バッチ学習では一度にすべての学習データを使ってパラメータ更新を行う

通常オンライン学習使うことが多い。全データをメモリに展開できないため

③ミニバッチ勾配降下法の重み更新の式の意味を図に書いて説明せよ

時間

12/11 1:20

コメント